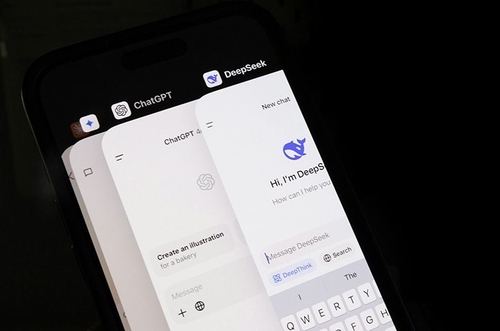

AI 챗봇 챗GPT와 딥시크[Royal Society Open Science, Uwe Peters et al. 제공. 재판매 및 DB 금지][Royal Society Open Science, Uwe Peters et al. 제공. 재판매 및 DB 금지]

AI 챗봇 챗GPT와 딥시크[Royal Society Open Science, Uwe Peters et al. 제공. 재판매 및 DB 금지][Royal Society Open Science, Uwe Peters et al. 제공. 재판매 및 DB 금지]챗GPT와 딥시크 등 일반에 널리 사용되는 AI 챗봇이 과학 논문을 요약할 때 최대 73%에서 부정확한 결론을 내린다는 연구 결과가 나왔습니다.

네덜란드 위트레흐트대와 캐나다 웨스턴대, 영국 케임브리지대 공동 연구팀은 챗GPT-4o와 딥시크 등 대표적인 AI 챗봇 10개 모델이 생성한 과학 논문 요약문 약 4천900건을 분석했습니다.

분석 결과 AI 생성 요약문 가운데 최대 73%에서 원문의 신중한 표현을 더 과장되게 일반화하는 편향이 발견됐습니다.

예를 들어 원문이 "치료법이 효과적이었다"는 신중한 과거형 표현을 "치료는 효과적이다"와 같이 확정적인 현재형으로 바꾸는 형태입니다.

특히 연구팀은 '부정확성을 피하라'고 요구할 경우 오히려 과도한 일반화가 두 배 가까이 증가했고, 최신 모델이 구형 모델보다 정확성이 더 떨어졌다고 지적했습니다.

연구팀은 AI가 정확성보다 유창하고 광범위한 답변을 선호하는 방향으로 학습됐기 때문이라며, AI 요약의 신뢰도를 높이기 위해서는 AI의 창의성을 조절하는 온도 값을 낮추고, 요청할 때도 명확히 과거 시제 사용을 지시하는 등의 방법이 필요하다고 조언했습니다.

연합뉴스TV 기사문의 및 제보 : 카톡/라인 jebo23

이경태(ktcap@yna.co.kr)

당신이 담은 순간이 뉴스입니다!

- jebo23

- 라인 앱에서 'jebo23' 친구 추가

- jebo23@yna.co.kr

ⓒ연합뉴스TV, 무단 전재-재배포, AI 학습 및 활용 금지